数据湖仓

除了对本地数据进行高效分析外,StarRocks 还可以作为计算引擎来分析存储在数据湖(例如 Apache Hudi、Apache Iceberg 和 Delta Lake)中的数据。 StarRocks 的主要功能之一是其外部 Catalog,它可以作为与外部维护的元存储的链接。此功能为用户提供了无缝查询外部数据源的功能,无需数据迁移。因此,用户可以分析来自不同系统(如 HDFS 和 Amazon S3)的各种文件格式(如 Parquet、ORC 和 CSV 等)的数据。

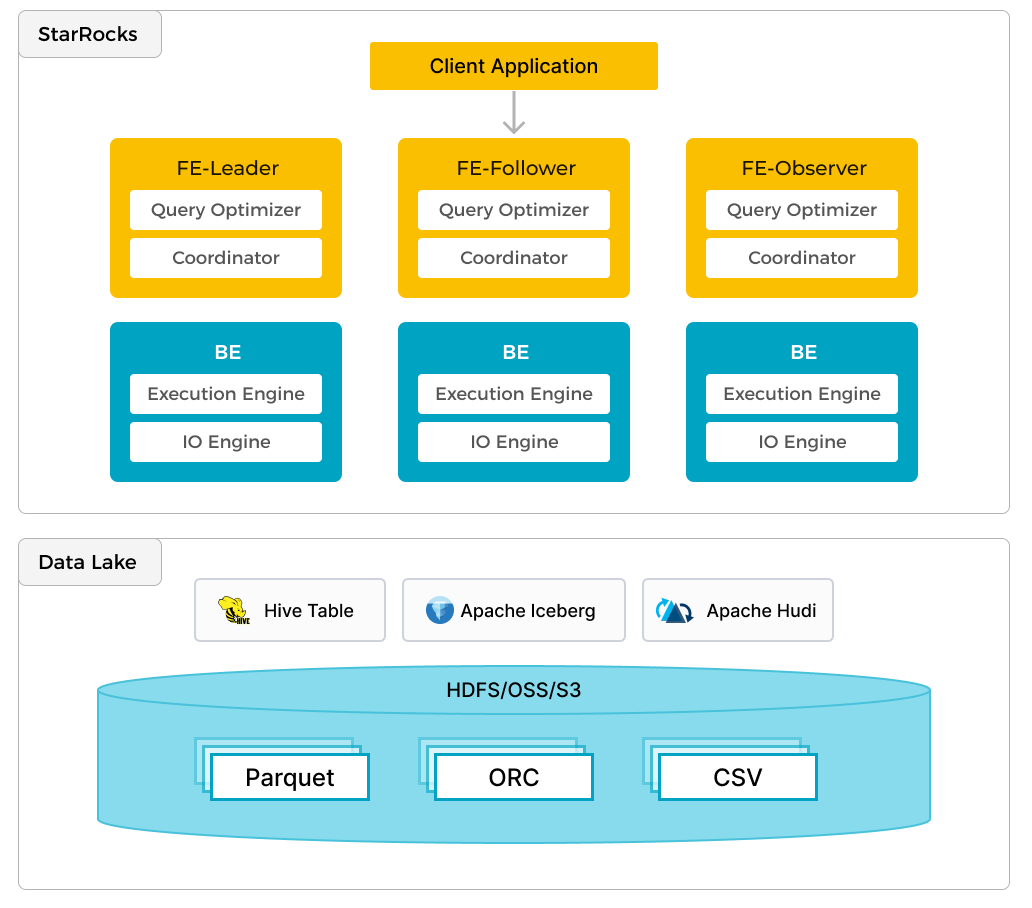

上图显示了一个数据湖分析场景,其中 StarRocks 负责数据计算和分析,而数据湖负责数据存储、组织和维护。 数据湖允许用户以开放存储格式存储数据,并使用灵活的模式来生成关于各种 BI、AI、ad-hoc 和报告用例的“单一事实来源”的报告。 StarRocks 充分利用了其向量化引擎和 CBO 的优势,显着提高了数据湖分析的性能。

关键理念

- 开放数据格式:支持各种数据类型,包括 JSON、Parquet 和 Avro,方便存储和处理结构化和非结构化数据。

- 元数据管理:实现共享元数据层,通常利用像 Iceberg 表格式这样的格式来有效地组织和管理数据。

- 治理和安全性:具有强大的内置机制,可用于数据安全、隐私和合规性,从而确保数据的完整性和可信度。

Data Lakehouse 架构的优势

- 灵活性和可伸缩性:无缝管理多样化的数据类型,并根据组织的需求进行扩展。

- 成本效益:与传统方法相比,为数据存储和处理提供了一种经济的替代方案。

- 增强的数据治理:改善数据控制、管理和完整性,确保可靠且安全的数据处理。

- AI 和分析就绪:非常适合复杂的分析任务,包括机器学习和 AI 驱动的数据处理。

StarRocks 的方法

需要考虑的关键事项是

- 标准化与 Catalog 或元数据服务的集成

- 计算节点弹性伸缩

- 灵活的缓存机制

Catalog

StarRocks 有两种类型的 Catalog:内部 Catalog 和外部 Catalog。 内部 Catalog 包含存储在 StarRocks 数据库中的数据的元数据。 外部 Catalog 用于处理外部存储的数据,包括由 Hive、Iceberg、Delta Lake 和 Hudi 管理的数据。 还有许多其他的外部系统,链接位于页面底部的“更多信息”部分。

计算节点 (CN) 伸缩

存储和计算分离降低了扩展的复杂性。 由于 StarRocks 计算节点仅存储本地缓存,因此可以根据负载添加或删除节点。

数据缓存

计算节点上的缓存是可选的。 如果您的计算节点根据快速变化的负载模式快速启动和关闭,或者您的查询通常只针对最新的数据,那么缓存数据可能没有意义。

更多信息请参见Catalog 文档。